記者陳金金 / 台北報導

AI 浪潮席捲全球,從自動駕駛、智慧醫療、大型語言模型(LLM),到近期橫空出世的Deepseek,無不讓各界把焦點放在 AI 晶片之上。然而,晶片 (NVIDIA) 與雲端 (AWS) 兩大龍頭的頻繁合作,似乎意味著 AI 算力佈局正悄悄的延伸至另一個戰場──雲端資料中心。

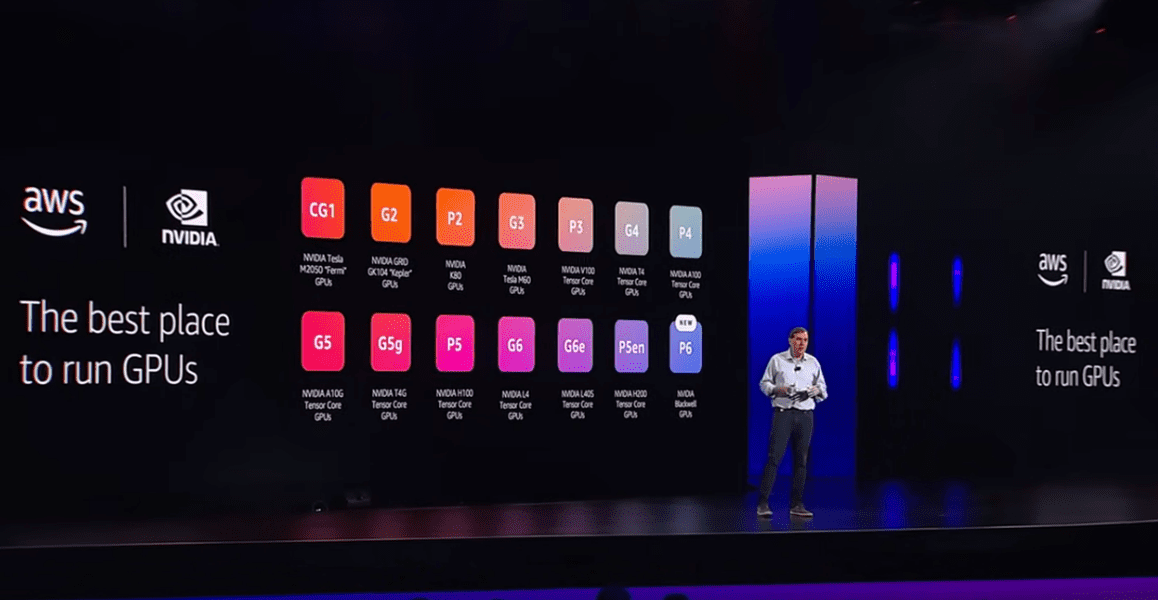

兩大龍頭去年6月再度攜手,除了推出搭載自家 AI 超級晶片與雲端運算擴充技術的 AI 超級電腦,也將 NVIDIA DGX Cloud 上到 AWS 雲端平台,為客戶提供 AI 訓練服務,還預計推出「計畫代號Project Ceiba」的最快 GPU AI 超級電腦,2024年3月NVIDIA 與 AWS 的聯合新聞稿中更直言「雙方持續的創新讓AWS成為在雲端中運行 NVIDIA GPU 的最佳所在」 (“Together, we continue to innovate to make AWS the best place to run NVIDIA GPUs in the cloud.”)這一波連串發力,更是讓業界驚呼不斷。

晶片與雲端的一哥搭檔,不僅為了趁早在 AI 服務百花齊放前,拉大與各自對手的領先差距,雙方也清楚明白,一旦人工智慧大量以雲端形式出現在各種場景服務用戶,算力就不再單純來自一顆顆高效 GPU堆疊組合下的表現,而是必須有強大快速的雲端運算做為後盾。

目前,AWS在五大洲擁有 36 座區域級資料中心據點(AWS Region),用來服務來自四面八方的客戶,其量能足以為NVIDIA或其他逐鹿 AI 商機的企業搶下雲端運算的地利之勢。

雲端跳島! AI的關鍵戰場:資料中心

根據 NVIDIA 官方資料,AWS 是全球首家提供 NVIDIA A100 和 H100 Tensor Core GPU 雲端運算的供應商,AWS 執行個體 Amazon EC 2 P5與G5 專供 AI 訓練與推理之用,兩大龍頭何做早已行之有年,包含去年六月合作推出的AI 超級電腦,也是運行在AWS的服務之上。

這 36 座被命名為 AWS Region 的資料中心據點,講求有效分流、就近使用,每一個據點之下均擁有至少3個以上的「AZ(Available Zone)可用區域」,為鄰近地理位置的各國用戶提供「運算、儲存、資料庫、網路、人工智慧」等服務,且擁有獨立專屬的電力、冷卻、網路系統來維持運作與備援。換言之,它就好比在世界各地都有前進基地,能快速且有規模佈署的算力資源,由此推斷,兩大龍頭攜手的動機,正是希望以用 36 座區域級資料中心據點在全球的覆蓋度,為 AI 算力佈局再下一城。

能源危機:AI 算力佈局背後的「隱形成本」

「洪師傅,嘗試切它電路!」當AI打敗人類棋王,這句借鏡電影葉問的玩笑話,卻直接戳中了 AI 背後的能源問題,該問題也被專家認為是企業押寶 AWS 的重要關鍵之一。

美國能源總署統計,2023 年全球資料中心總用電達到460 TWh(太瓦時),佔全球總用電量的 2%,在愛爾蘭與美國部分州郡占比更逾 20% 以上。

全球資料中心用電量預估2030年將突破 1,000 TWh。

在過去亞馬遜發出的新聞稿亦指出, 亞馬遜計畫在 2025 年實現全球基礎設施 100% 使用再生能源。不僅如此,AWS也宣稱其「節能冷卻技術」和「雲端自動化調度」可在追求AI算力的同時,大幅降低能耗,這對於需電力密集作業的 AI 訓練服務可說是一大福音。

「沒有能源沒有AI,政府與產業需要合作,確保電力供應的安全與永續發展。」國際能源總署執行董事比羅爾(Fatih Birol)曾如此直言。

此外,長年對雲端資安與個資保障的投入,也讓許多對雲端存疑的政府及企業對 AWS 吃下定心丸。被外界視為較為審慎的日本政府,也在2020年於其上建立超過20個政府核心系統,包含美國政府以及國防、情報部門也早已是雲端服務的使用者。各國政府上雲也被認為是對雲端資安信任的一大步。

算力佈局:台灣企業拒絕落於人後

「未來具大量機敏資料的企業不用再將資料傳到境外,藉由使用台灣資料中心保障安全」(引用來源:https://www.bnext.com.tw/article/79396/amazon-aws-cloud-region-taiwan-local-ai-compute)

值得一提的是,目前距離台灣最近的資料中心據點有大阪、東京、首爾、香港等四地,2025年台灣當地的AWS Region也將啟用,這也不免讓人對早先NVIDIA宣布在台設立海外總部有所聯想。

然而,NVIDIA並非 AWS 唯一在算力佈局上合作的知名客戶,同樣受惠於 AWS 雲端資源的知名企業還有 Netflix 與 Airbnb,藉由AWS Region資料中心的運算、儲存、架構、AI技術,前者服務了全球超過190個國家共2.8億會員、後者則接待逾 220 個國家共 10 億旅客。

若再以目前當紅的生成式 AI 來說,也有 BMW、Pfizer、西南航空、Canva、Booking.com 等一眾響噹噹的企業接入 AWS Region,並運用其中的 Amazon Bedrock(AWS推出的AI基礎層服務),執行市場主流的大型語言模型(LLM)與基礎模型(FM),藉此服務自家消費用戶。

「AWS Region可以為這些企業在降低成本、提升效能、加速創新上帶來顯著效益,要歸功於其全球覆蓋、高可用性、彈性擴展、安全防護四大優勢」一位業界資深專家指出。

如何選擇 AI 資料中心? 五大決策要點

摩根大通2024年曾指出,未來四年資料中心的缺口會持續擴大,供不應求之下導致價格上升,然而,台灣 AI 產業正在快速成長,企業在接入資料中心時,宜避免花冤枉錢又得不到預期效益,接軌AI反成悲哀。對此專家指出,以下五個決策要點可供企業審慎評估:

雲端擴展性:具備彈性計算能力,可依 AI 訓練需求擴展算力,並且能支援不同的AI應用場景、模型與對應的GPU、CPU、ASIC配置。

市場競爭力:是否有足夠的 AI 資源與訓練資源,以加速創新服務研發,此點與雲端算力與擴展性高多相關,直接影響到終端用戶的使用體驗。

能源與成本:評估電力來源與節能程度是否符合永續規範,確保 AI 運算的可持續性,也確保能同時達到經濟與環境的雙贏效益。

數據與資安:選擇符合各國或國際安全標準的雲端平台,確保企業 AI 運算數據的安全與用戶個資保障、是否符合公司治理中的嚴格要求,同時能防範外洩與網路攻擊,保護企業的數據資產。

整合與管理:是否能與企業雲端或地端高度整合,甚至評估是否有相關服務能幫助地端快速搬遷上雲,其管理、開發、技術支援是否能有助效率提升。

摩根大通也在同一份報告指出阻礙資料中心發展的原因,包括:土地有限、資本昂貴、設備限制、法規許可、電力輸送、勞動力供應等問題。依此態勢,即便是超大型的全球級企業,要自行打造且妥善維護也絕非易事,採用公有雲資料中心基本上已是大勢所趨,中型小型企業亦然。

已故哈佛商援院教授,也是破壞式創新提倡者克雷頓.克里斯汀生(Clayton Christensen)曾說:「面對永無止盡的科技變革,彷彿攀登沿山丘而下的泥流,你必須永遠保持在其之上,只要停頓下來、稍喘一口氣,就會滅頂。」面對當今的AI群雄爭霸正好用以借鏡,在為算力佈局時,讓雲端先行前頭,打通連結企業的任督二脈,擘畫出一條通往未來的商業戰略之道!

林宜隆理事長(全球網際空間管理暨產業發-360x180.jpg)

欣賞謝德祥副總(右)在裝修業的專業實力,並認為天然防潮石膏磚)-360x180.jpg)